Как компенсировать слабую видеокарту

Обновлено: 28.06.2024

Проблемы и их решение

Встроенные или интегрированные (iGPU) в современные процессоры видеокарты справляются со многими компьютерными играми. Для AAA-проектов на высоких настройках они не годятся, но кое что все же могут. Рассмотрим особенности работы встроенных графических ускорителей с памятью.

Сколько памяти у встроенной видеокарты

Интегрированные видеокарты не имеют собственной памяти. Ее черпают из оперативной памяти: в зависимости от настроек BIOS/UEFI или операционной системы, Windows резервирует определённый объём оперативной памяти, которая используется встроенным видеоускорителем в качестве видеопамяти (VRAM).

Обычно графика встраивается в центральный процессор, на некоторых ноутбуках распаивается на материнской плате. Во втором случае это самостоятельное, но несъемное устройство – псевдодискретная графика.

Как увеличить или уменьшить объем видеопамяти

Размер выделяемой операционной системой встроенной видеокарте памяти изменяется двумя способами:

- Автоматически или динамически – система выделяет такой объём ОЗУ, который на данный момент необходим графическому процессору для выполнения поставленных задач.

- Вручную – фиксированное значение, установленное на заводе или пользователем вручную.

Зачем изменять размер видеопамяти?

При изменении размера графической памяти важен баланс. Отданная для видеокарты ОЗУ резервируется операционной системой и не может использоваться ею либо приложениями. Если на компьютере установлено мало ОЗУ – 2-4 ГБ, смысл в выделении большого объема видеопамяти в ущерб оперативной есть не всегда.

Положительно на быстродействии графики сказывается разгон оперативки, но прирост FPS не превышает нескольких процентов.

Где посмотреть объем

Увидеть, сколько памяти выделено интегрированному графическому ядру, можно несколькими способами.

Параметры Windows 10

Диспетчер задач

Первая цифра – занятая память, вторая – выделенная.

Также процент задействования VRAM отображают сторонние утилиты, например, HWiNFO.

Изменить через BIOS

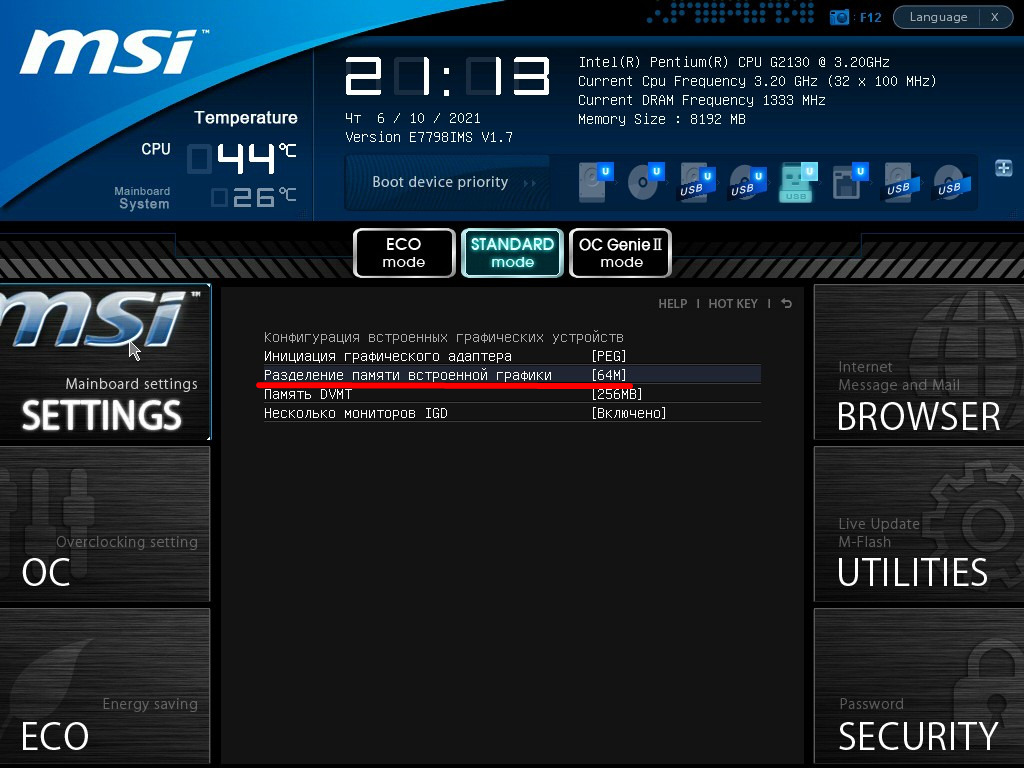

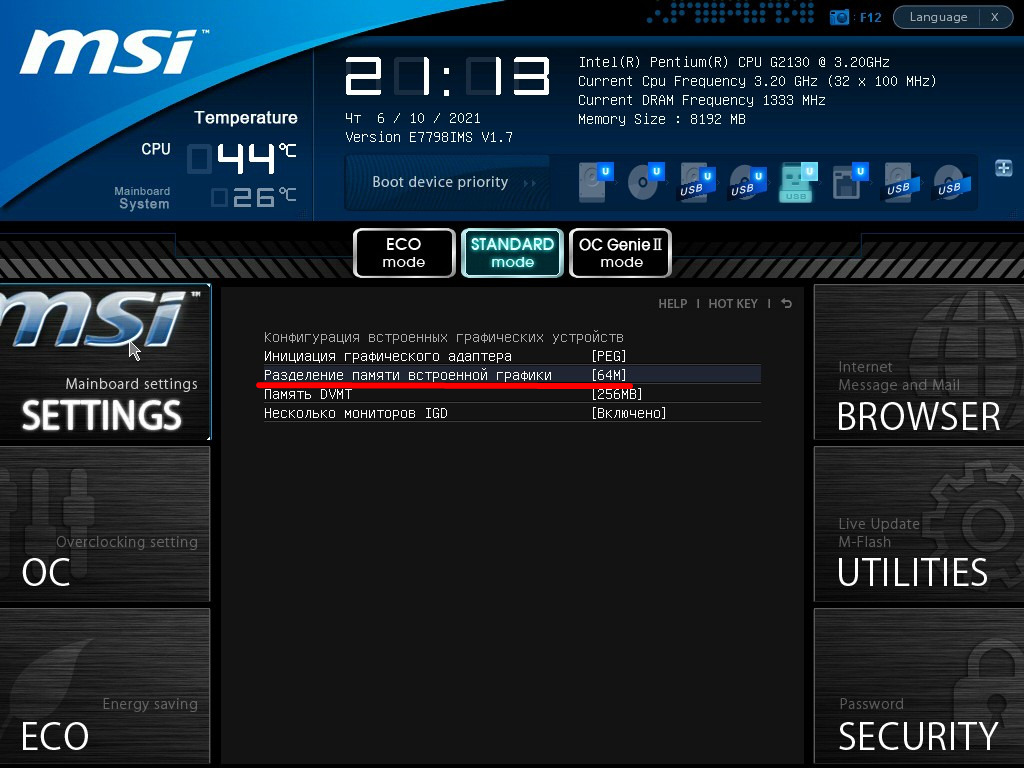

Расширяется и урезается графическая память в настройках BIOS/UEFI.

Дальнейшие действия могут отличаются для различных производителей BIOS/UEFI, но в целом они похожи. Рассмотрим на примере материнки от MSI.

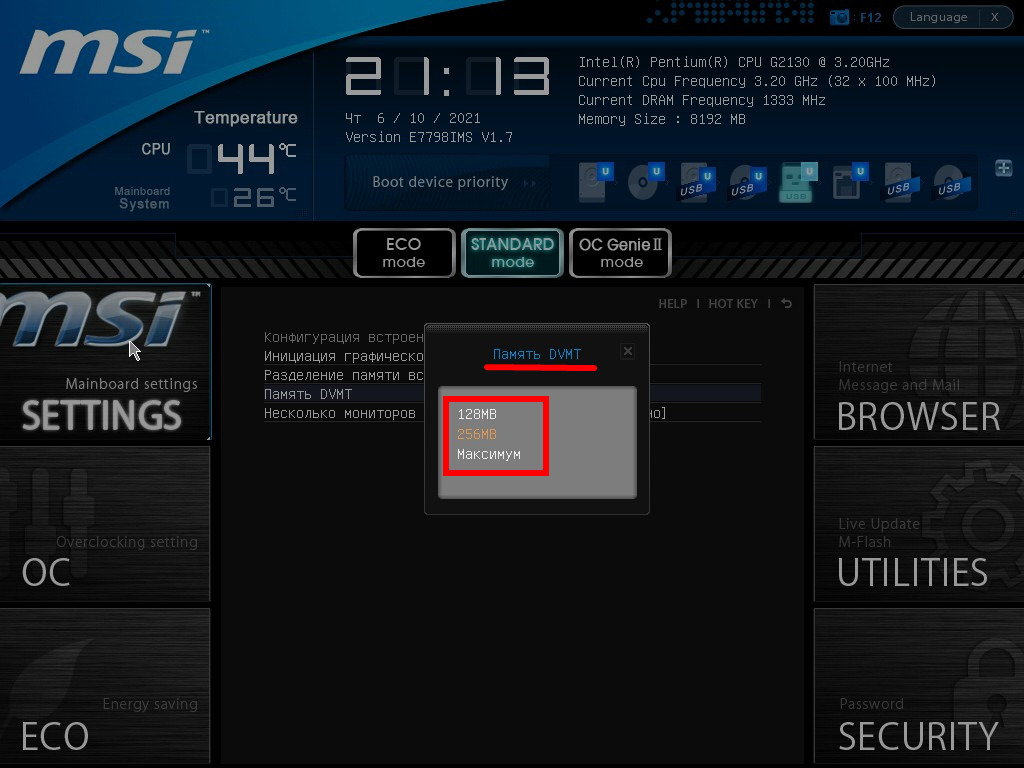

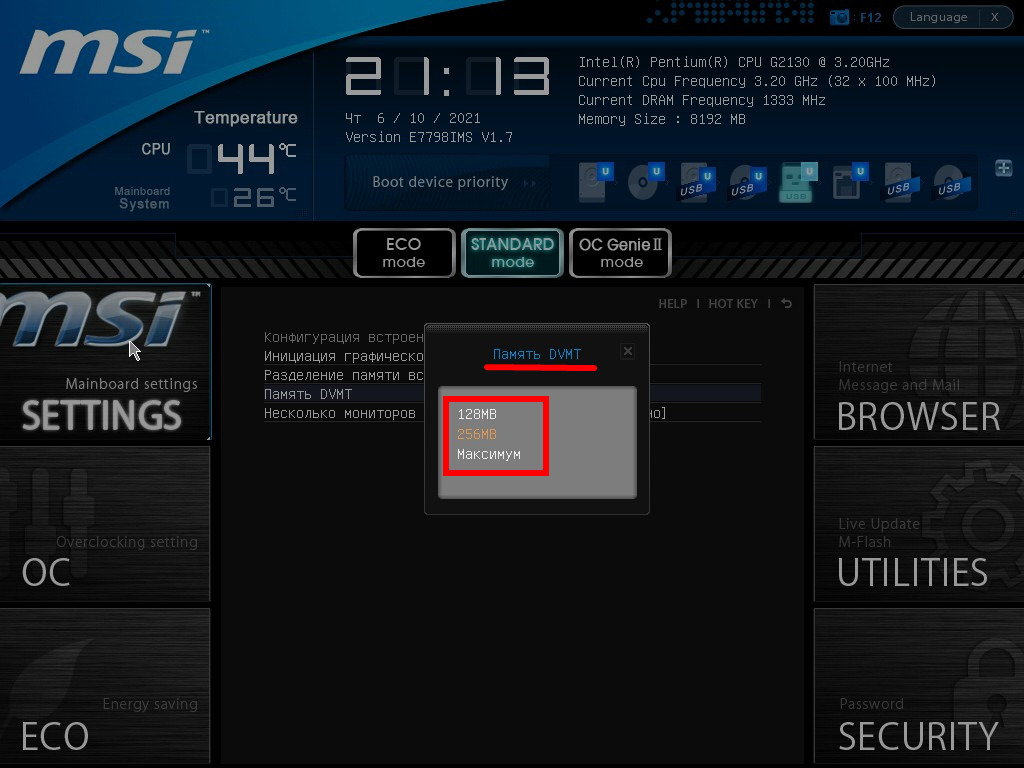

Укажите нужный объём, после чего нажмите F10 для выхода с сохранением настроек.

В настройках можно указать максимальный размер ОЗУ, отдаваемый под VRAM.

Иногда при включении DVMT память видеокарте выделяется, но приложения её не видят и, соответственно, не запускаются. Выдают ошибку, что объём выделяемой для графики памяти меньше минимальных системных требований игры или программы.

Реестр

Изменяется значение и через реестр. Такой прием удобно использовать если игра не запускается с ошибкой о нехватки видеопамяти.

Два раза щелкните по записи левой клавишей, переключите систему счисления на десятичную.

Сколько ставить

Рекомендуется ставить не более 256 МБ для 2 ГБ оперативки, 512 МБ – для 4 ГБ и максимум для 6 и более ГБ. Как правило, современные системы выделяют 2 ГБ для встроенной графики по умолчанию. Если вы не испытываете проблем с нехваткой оперативной памяти — можете не уменьшать этот параметр.

Влияние характеристик оперативной памяти на производительность iGPU

Скорость оперативной памяти оказывает влияние на быстродействие компьютера в играх, частоту кадров. При замене планок с частотой памяти 1866 Гц на 2400 Гц стремительного роста производительности ждать не стоит. Прирост FPS будет незначительным – до нескольких кадров или процентов в секунду. Всё зависит от конфигурации оборудования и самой игры.

Ну к примеру я брал оперативку с частотой равной ЦП, но была проблема: мать напрочь отказывалась запускать оперативу на родных частотах и снижала их до рекомендованных под проц, а при ручном подрубе ПК уходил в вечный перезапуск и постоянно жутко матерился пискуном. В общем решил проблему т.к. в хорошую видеокарту вкидываться не имеет смысла, встройка и так тянет все не в 4k конечно, да оно и нафиг ненужно, пусть глупцы садят глаза… И главное убивает маркетинг. ФПС это ведь кадры в секунду. А герц что это? Да тоже самое! Так пусть мне объяснят наивные чукотские юноши, что они видят разницу в ФПС выше 40 кадров, если они не видят как мигает лампа ильича, а я блин вижу и скажу: 62 ФПС или они же ГЦ в секунду для человеческого глаза предел. Ну и самая соль под конец: как вы глупцы видите 200 ФПС что значит кадров в секунду, на мониторах 70 Гц, то есть 70 кадров в секунду? Мно таких клоунов поставил на место, показав и объяснив, что кадры выше возможности монитора не скачут на экране. Я лично имею отменный моник, но у меня фрисинк настроен на 62 Гц вручную т.к. современные экраны вообще не мерцают, да и на лучевой трубке я видел 60 Гц мерцание, а вот на 62 их у же невидно. Проблему с оперативой решил следующим образом: после сохранения параметров материнка уходит в самотест и диагностику, начинает пищать много при перезагрузке. И так постоянно, но ПК так и не стартует. Так вот после сохранения в биосе частоты ПК вручную, при перезагрузке сразу слышим как ПК неоднократно матерится тут же жмём кнопку выключения и даём ему постоять от 20 до 30 секунд. Потом включаем, долгое молчание около 40 секунд и ПК стартует, видимо какие-то из кондёров не успевают разрядиться 😉 И да, для любителей поспорить в виндовс по умолчанию было 60 и 72, но в ручную всё это делается и делалось, что в виндовс, что в драйвере 😉

В предыдущих статьях мы поговорили про мифы о процессорах, оперативной памяти и материнских платах, теперь же перейдем к видеокартам, которые уже давно стали обязательной частью любого компьютера.

Первый миф. Чем больше видеопамяти — тем быстрее видеокарта

Казалось бы, это логично — в более мощные видеокарты ставится больше памяти: так, GTX 1070 с 8 ГБ памяти быстрее, чем GTX 1060 с 6 ГБ, а GTX 1080 Ti с 11 ГБ быстрее GTX 1080 с 8 ГБ. Однако следует понимать, что видеопамять, конечно, важна, но зачастую различное ПО не использует всю имеющуюся у видеокарты память: так, в большинстве случаев GTX 1060 с 3 ГБ медленнее версии с 6 ГБ всего на 5-10%, и разница в основном идет из-за различного числа CUDA-ядер.

Так что не стоит судить о производительности видеокарты, опираясь только на объем видеопамяти.

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Опять же, это кажется логичным: если видеокарте памяти не хватило, взять ее больше неоткуда — значит, программы корректно работать не смогут. Однако на деле это, разумеется, не так — любая видеокарта имеет доступ к оперативной памяти, которой обычно куда больше, чем видеопамяти. Конечно, ОЗУ в разы медленнее, а время доступа к ней больше — это может вызвать проблемы с плавностью картинки, но только лишь в том случае, если собственной памяти видеокарте не хватает сильно: например, у нее 2-3 ГБ памяти, а игра требует 4-5 ГБ. Но если не хватает нескольких сотен мегабайт, то обычно это проблем не вызывает: GPU умеют динамически использовать доступные им ресурсы, и в ОЗУ они стараются хранить ту информацию, которая нужна редко или не требует мгновенного отклика.

Третий миф. От разгона видеокарты сгорают

Четвертый миф. SLI/Crossfire увеличивают производительность и объем видеопамяти во столько раз, сколько видеокарт подключено

Насчет производительности это, скорее, не миф, а теоретический результат. Увы — на практике, хотя тому же SLI 20 лет, а Nvidia его использует больше 10 лет, в большинстве игр прирост или околонулевой, или вообще отрицательный. Лишь в единичных проектах можно получить прирост хотя бы 20-30% в сравнении с одной видеокартой, что, конечно, смешно, с учетом двукратного увеличения стоимости и серьезных требований к блоку питания. Что касается вычислительных задач, то тут все сложнее: так, профессиональный софт вполне может использовать несколько GPU эффективно, но это уже не домашнее применение.

Что касается видеопамяти, то тут все просто: при использовании DirectX 11 или ниже в видеопамять каждого используемого GPU записывается одинаковая информация, то есть у связки видеокарт будет по сути тот же объем памяти, что и у одиночной карты. А вот в API DirectX 12 есть возможность более эффективно использовать Split Frame Rendering, когда каждая видеокарта готовит свою часть кадра. В таком случае объемы видеопамяти суммируются — пусть и с оговорками.

Пятый миф. Профессиональные видеокарты лучше игровых

Шестой миф. Если видеокарта не раскрывается процессором — это плохо

Легко можно получить и обратную ситуацию: взять ту же самую GTX 1080 Ti и запустить на ней игру в HD-разрешении с минимальными настройками графики — и тут даже Core i9-9900K не сможет подготовить для ней столько кадров в секунду, чтобы она была занята на 100%.

Так что тут можно сделать два вывода: во-первых, если видеокарта недогружена несильно, а итоговый fps вас устраивает — всегда можно еще немного увеличить настройки графики, чтобы получить 100% нагрузку на видеокарту с лучшей картинкой и при той же производительности. Во-вторых, собирайте сбалансированные сборки, дабы не было такого, что процессор занят на 100%, а fps в игре 20 кадров.

Седьмой миф. Чем уже шина памяти — тем ниже производительность видеокарты

Восьмой миф. Если видеокарта не перегревается, то она работает на максимально возможной для нее частоте в рамках ее теплопакета

Увы — аналогия с процессорами тут не работает: если те действительно удерживают максимальные частоты в рамках TDP вплоть до температуры, с которой начинается троттлинг из-за перегрева, то видеокарты работают хитрее: так, у Nvidia есть технология GPU Boost, которая, с одной стороны, является аналогом Turbo Boost для процессоров — позволяет поднимать частоту выше базовой — а с другой стороны имеет больше ограничений.

Возьмем, для примера, GTX 1080 Ti. Она имеет родную частоту в 1480 МГц, а Boost — 1580. Но стоит нагрузить видеокарту, как частота может подскочить до 1800-1850 МГц — то есть выше Boost: это и есть работа технологии GPU Boost. Дальше — интереснее: критические температуры у видеокарт поколения Pascal составляют порядка 95 градусов — но уже при 85 можно заметить, что частоты снижаются ближе к уровню Boost. Почему так? Потому что Nvidia ввела еще одну опорную температуру, которую называет целевой: при ее достижении видеокарта старается ее не превышать, а для этого сбрасывает частоты. Так что если у вас мощная видеокарта, да и еще с референсным турбинным охлаждением — внимательно следите за температурами, ибо от них в прямом смысле зависит производительность.

Девятый миф. Видеокарты без дополнительного питания хуже аналогов с ним

В продаже можно встретить видеокарты уровня GTX 1050, 1050 Ti и AMD RX 550 без дополнительного питания — то есть, как в старые добрые времена, достаточно поставить их в слот PCIe и они готовы к работе. При этом также есть версии 1050 и 1050 Ti с дополнительным питанием 6 pin, из-за чего некоторые пользователи делают вывод, что раз дополнительное питание есть — значит с ним видеокарты будут работать лучше.

На деле это не совсем так: слот PCIe способен дать видеокарте до 75 Вт, и этого вполне хватает, чтобы даже 1050 Ti работала на указанных на официальном сайте Nvidia частотах. Но если вы нацелены на разгон — да, тут питания от PCIe видеокарте может уже не хватить, так что дополнительные 6 pin от блока питания позволят достичь больших частот, однако разница в любом случае не превысит 10%.

Десятый миф. Не стоит ставить современные PCIe 3.0 видеокарты на старые платы со слотами PCIe 2.0 или 1.0

Все опять же логично — так, пропускная способность PCIe 2.0 x16 вдвое ниже, чем у 3.0 x16, а, значит, современные видеокарты через более старую шину PCIe будут работать медленнее. На деле это опять же не так — пропускная способность PCI Express 3.0 x16 даже для топовых современных видеокарт оказывается избыточной:

Хорошо видно, что разница между 3.0 x16 и 2.0 x16 составляет всего 1%, то есть погрешность, и даже если спуститься до PCIe 1.1 — то есть к материнским платам почти десятилетней давности — падение производительности оказывается всего лишь 6%. Так что вердикт тут прост — версия PCIe практически не влияет на производительность видеокарты, соответственно можно смело к Xeon с PCI Express 2.0 брать GTX 1080.

Одиннадцатый миф. Разгон видеопамяти не имеет смысла

Конечно, наибольший прирост дает разгон ядра видеокарты — тут прирост производительности близок к линейному (то есть увеличили частоту на 10% — получили прирост производительности на 10%). Однако не стоит сбрасывать со счетов видеопамять, особенно в слабых видеокартах: зачастую в них ставят те же чипы памяти, что и в более мощные решения, но при этом сильно снижают частоту. Это дает возможность ее достаточно сильно разогнать, зачастую на 20-40%, что может прибавить к общей производительности графики еще 10-15% — для слабых видеокарт это лишним, разумеется, не будет:

Двенадцатый миф. С выходом каждой новой линейки видеокарт производители урезают производительность старой

Но почему тогда есть разница в производительности между драйверами? Потому что ничто в нашем мире не идеально, и какие-то драйвера, улучшая производительность в новых играх, могут испортить производительность в более старых или привести к различным ошибкам. Обычно через некоторые время выходят исправленные драйвера, и все возвращается на круги своя.

Если вы знаете еще какие-либо мифы — делитесь ими в комментариях.

Ещё один миф. С выходом новой линейки видеокарт, старые дешевеют. Нвидиа это успешно опровергала, просто накрутив цену на новые карты))

А может быть, ВНЕЗАПНО, стоит поставить более быстрый процессор, и FPS будет выше за счёт простаивавших мощностей GPU?

Более половины всех мифов правда.

первый миф так сказать вытекает из второго если видеокарта наталкивается на приложение где нужно больше памяти растет требование к ее пропускной способности. это заметно приводит к покере производительности процентов так на 20, параллельно растет требование к пропускной способности всей системы что можно игру там реально затормозить до 5 фпс с дикими фризами и выпадениями текстур как в раге. хотя как бы то исходя из мощности самого чипа и процессора игра должна работать в реальном времени. и она будет если снизить текстуры. в свою очередь обработка текстур высокого разрешения влияет на производительность очень не существенно. проблемы усугубляются если например в системе сли, кросс фаер или 2х чиповая карта аки 690 а подключено все это на амд фх который пропускной способностью и скоротечность куша не блещет плюс все это хозяйство еще через северный мост и 5гб сек. миф не работает только с бюджетными картами и не понимаем сути задач для которых карта берется. например чешет такой ПеКа репу некий абстрактный школьник какую бы карту возжелать 1060 3гб или то 1050 4гб. вторая в типовых профильных игровых зач будет не круче. а вот еще была такая значится карта фури х 4гб и 390 8 гб там какая то. фури х мощнее и память у ней быстрей но были там какие то означится игры где карта начисто соснула у более слабой карты но с большим объемом врама. то есть потеря производительности на самом деле запредельная. про сли и мульти гпу я уже неоднократно пека утверждал - проверено что с 2мя картами они дают 100% прирост на уровне погрешности если соблюдены ряд условий и очень чудовищная нагрузка на каждый гпу. до 40 фпс они обычно отлично масштабируются. и как бы нет причин чтоб это условие не выполнялось и для 4гпу если не перегружать шину. память они не суммируют но теоретически могут. практически правда то это значит нет. турбобуст видеокарты зависит от температурки это значится правда в зависимости от моделей. под высокое температуры этот турбо обычно не активируется

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Фризы тебе точно гарантированы,и естественно это не миф,попробуй запустить RE7 или Rise of the Tomb Raider с максимальными текстурами на видяхе с 4 гагами памяти,и получишь гарантированные фризы,собственно это мои случаи когда у меня ещё была GTX980,стоило снизить текстуры на один пункт и фризы естественно прекращались.

saa0891 DDR4 более чем достаточно, чтобы по крайней мере не было фризов, так что если не хватает VRAM можно просто добавить воды. gennaz Eh. Евгений Кондратенко Да лучше уж 970 по дешевке ищет и не будет парится в новых игорях.

бестолковые блоги для получения бонусов

добавлю от себя и своего опыта владения около 7 видеокартами в течении 7лет: 2 - фризов и вылетов не будет, но может резко просесть фпс или подгружаться текстуры противников будут прямо перед носом 3- у всего есть свой срок службы при эксплуатации в определённых условиях 7- зависит от оптимизации игры и её способности разбивать данные на меньшие блоки, что упрощает работу видеокарты с узкой шиной 10- чисто из опыта с R7 370: фпс скакало больше на PCIe 2.0 при чём на том же процессоре и оперативке

Еще один миф. С выходом новой линейки старые должны дешеветь. Это широко распространенный миф. Ибо рынок живет по другим законам. Если конкуренты не могу предоставить даже на старую линейку достойной конкуренции. С чего это новая линейка более быстрая должна быть по той же цене что и старая. И уж тем более еще более быстрые карты должны быть по аналогичной цене старой линейки аналогов конкурента. Проще говоря если бы АМД представяла конкурирующие решения на старую линейку то новая линейка Нвидиа была бы дешевле. А так скажите спасибо АМД за ее технологическую импотенцию.

Однако на деле даже решения 600-ой линейки от Nvidia, вышедшей более 6 лет назад, до сих пор получают новые драйвера наравне с более новыми видеокартами Перед тем,как писать данную статью,автору стоило бы зайти на сайт нвидиа и убедиться,что сейчас поддерживаются видеокарты от 700 серии и выше.

gennaz Чувак, помоему это следовало сделать тебе, прежде, чем писать эту дичь.

Евгений Кондратенко Хм, думаешь я не посмотрел,прежде чем писать?))) Это "поддержка" только на бумаге,а на деле вот так

gennaz Т.е. ты запустил на gt630 новую ларку и ждёшь 60фпс в 4к? А если нет то это драйвера плохие? Ты вообще адекватный.

gennaz Чувак, не страдай фигней и не выставляй себя дураком. Купи себе на авито хотя бы GTX 770 и будешь нормально играть. Такие карты стоят на авито 6000-7000р, зато на них не будет такого ахтунга, как у тебя на скриншоте. Да и сама по себе 770 отличная карточка, всё-таки предтоповая семисотка.

erkins007 Дело не в низком фпс,а в графических артефактах в этой игре на карте 600 серии.Евгений Кондратенко Сам себе купи такое фуфло! Да и достаточно было заглянуть в профиль,чтобы не предлагать покупать всякое старьё,у меня любые игры идут отлично, на достаточно приличных настройках.

Проблемы и их решение

Встроенные или интегрированные (iGPU) в современные процессоры видеокарты справляются со многими компьютерными играми. Для AAA-проектов на высоких настройках они не годятся, но кое что все же могут. Рассмотрим особенности работы встроенных графических ускорителей с памятью.

Сколько памяти у встроенной видеокарты

Интегрированные видеокарты не имеют собственной памяти. Ее черпают из оперативной памяти: в зависимости от настроек BIOS/UEFI или операционной системы, Windows резервирует определённый объём оперативной памяти, которая используется встроенным видеоускорителем в качестве видеопамяти (VRAM).

Обычно графика встраивается в центральный процессор, на некоторых ноутбуках распаивается на материнской плате. Во втором случае это самостоятельное, но несъемное устройство – псевдодискретная графика.

Как увеличить или уменьшить объем видеопамяти

Размер выделяемой операционной системой встроенной видеокарте памяти изменяется двумя способами:

- Автоматически или динамически – система выделяет такой объём ОЗУ, который на данный момент необходим графическому процессору для выполнения поставленных задач.

- Вручную – фиксированное значение, установленное на заводе или пользователем вручную.

Зачем изменять размер видеопамяти?

При изменении размера графической памяти важен баланс. Отданная для видеокарты ОЗУ резервируется операционной системой и не может использоваться ею либо приложениями. Если на компьютере установлено мало ОЗУ – 2-4 ГБ, смысл в выделении большого объема видеопамяти в ущерб оперативной есть не всегда.

Положительно на быстродействии графики сказывается разгон оперативки, но прирост FPS не превышает нескольких процентов.

Где посмотреть объем

Увидеть, сколько памяти выделено интегрированному графическому ядру, можно несколькими способами.

Параметры Windows 10

Диспетчер задач

Первая цифра – занятая память, вторая – выделенная.

Также процент задействования VRAM отображают сторонние утилиты, например, HWiNFO.

Изменить через BIOS

Расширяется и урезается графическая память в настройках BIOS/UEFI.

Дальнейшие действия могут отличаются для различных производителей BIOS/UEFI, но в целом они похожи. Рассмотрим на примере материнки от MSI.

Укажите нужный объём, после чего нажмите F10 для выхода с сохранением настроек.

В настройках можно указать максимальный размер ОЗУ, отдаваемый под VRAM.

Иногда при включении DVMT память видеокарте выделяется, но приложения её не видят и, соответственно, не запускаются. Выдают ошибку, что объём выделяемой для графики памяти меньше минимальных системных требований игры или программы.

Реестр

Изменяется значение и через реестр. Такой прием удобно использовать если игра не запускается с ошибкой о нехватки видеопамяти.

Два раза щелкните по записи левой клавишей, переключите систему счисления на десятичную.

Сколько ставить

Рекомендуется ставить не более 256 МБ для 2 ГБ оперативки, 512 МБ – для 4 ГБ и максимум для 6 и более ГБ. Как правило, современные системы выделяют 2 ГБ для встроенной графики по умолчанию. Если вы не испытываете проблем с нехваткой оперативной памяти — можете не уменьшать этот параметр.

Влияние характеристик оперативной памяти на производительность iGPU

Скорость оперативной памяти оказывает влияние на быстродействие компьютера в играх, частоту кадров. При замене планок с частотой памяти 1866 Гц на 2400 Гц стремительного роста производительности ждать не стоит. Прирост FPS будет незначительным – до нескольких кадров или процентов в секунду. Всё зависит от конфигурации оборудования и самой игры.

Ну к примеру я брал оперативку с частотой равной ЦП, но была проблема: мать напрочь отказывалась запускать оперативу на родных частотах и снижала их до рекомендованных под проц, а при ручном подрубе ПК уходил в вечный перезапуск и постоянно жутко матерился пискуном. В общем решил проблему т.к. в хорошую видеокарту вкидываться не имеет смысла, встройка и так тянет все не в 4k конечно, да оно и нафиг ненужно, пусть глупцы садят глаза… И главное убивает маркетинг. ФПС это ведь кадры в секунду. А герц что это? Да тоже самое! Так пусть мне объяснят наивные чукотские юноши, что они видят разницу в ФПС выше 40 кадров, если они не видят как мигает лампа ильича, а я блин вижу и скажу: 62 ФПС или они же ГЦ в секунду для человеческого глаза предел. Ну и самая соль под конец: как вы глупцы видите 200 ФПС что значит кадров в секунду, на мониторах 70 Гц, то есть 70 кадров в секунду? Мно таких клоунов поставил на место, показав и объяснив, что кадры выше возможности монитора не скачут на экране. Я лично имею отменный моник, но у меня фрисинк настроен на 62 Гц вручную т.к. современные экраны вообще не мерцают, да и на лучевой трубке я видел 60 Гц мерцание, а вот на 62 их у же невидно. Проблему с оперативой решил следующим образом: после сохранения параметров материнка уходит в самотест и диагностику, начинает пищать много при перезагрузке. И так постоянно, но ПК так и не стартует. Так вот после сохранения в биосе частоты ПК вручную, при перезагрузке сразу слышим как ПК неоднократно матерится тут же жмём кнопку выключения и даём ему постоять от 20 до 30 секунд. Потом включаем, долгое молчание около 40 секунд и ПК стартует, видимо какие-то из кондёров не успевают разрядиться 😉 И да, для любителей поспорить в виндовс по умолчанию было 60 и 72, но в ручную всё это делается и делалось, что в виндовс, что в драйвере 😉

Егор Морозов | 8 Декабря, 2018 - 15:52

В предыдущих статьях мы поговорили про мифы о процессорах, оперативной памяти и материнских платах, теперь же перейдем к видеокартам, которые уже давно стали обязательной частью любого компьютера.

Первый миф. Чем больше видеопамяти — тем быстрее видеокарта

Казалось бы, это логично — в более мощные видеокарты ставится больше памяти: так, GTX 1070 с 8 ГБ памяти быстрее, чем GTX 1060 с 6 ГБ, а GTX 1080 Ti с 11 ГБ быстрее GTX 1080 с 8 ГБ. Однако следует понимать, что видеопамять, конечно, важна, но зачастую различное ПО не использует всю имеющуюся у видеокарты память: так, в большинстве случаев GTX 1060 с 3 ГБ медленнее версии с 6 ГБ всего на 5-10%, и разница в основном идет из-за различного числа CUDA-ядер.

Так что не стоит судить о производительности видеокарты, опираясь только на объем видеопамяти.

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Опять же, это кажется логичным: если видеокарте памяти не хватило, взять ее больше неоткуда — значит, программы корректно работать не смогут. Однако на деле это, разумеется, не так — любая видеокарта имеет доступ к оперативной памяти, которой обычно куда больше, чем видеопамяти. Конечно, ОЗУ в разы медленнее, а время доступа к ней больше — это может вызвать проблемы с плавностью картинки, но только лишь в том случае, если собственной памяти видеокарте не хватает сильно: например, у нее 2-3 ГБ памяти, а игра требует 4-5 ГБ. Но если не хватает нескольких сотен мегабайт, то обычно это проблем не вызывает: GPU умеют динамически использовать доступные им ресурсы, и в ОЗУ они стараются хранить ту информацию, которая нужна редко или не требует мгновенного отклика.

Четвертый миф. SLI/Crossfire увеличивают производительность и объем видеопамяти во столько раз, сколько видеокарт подключено

Насчет производительности это, скорее, не миф, а теоретический результат. Увы — на практике, хотя тому же SLI 20 лет, а Nvidia его использует больше 10 лет, в большинстве игр прирост или околонулевой, или вообще отрицательный. Лишь в единичных проектах можно получить прирост хотя бы 20-30% в сравнении с одной видеокартой, что, конечно, смешно, с учетом двукратного увеличения стоимости и серьезных требований к блоку питания. Что касается вычислительных задач, то тут все сложнее: так, профессиональный софт вполне может использовать несколько GPU эффективно, но это уже не домашнее применение.

Что касается видеопамяти, то тут все просто: при использовании DirectX 11 или ниже в видеопамять каждого используемого GPU записывается одинаковая информация, то есть у связки видеокарт будет по сути тот же объем памяти, что и у одиночной карты. А вот в API DirectX 12 есть возможность более эффективно использовать Split Frame Rendering, когда каждая видеокарта готовит свою часть кадра. В таком случае объемы видеопамяти суммируются — пусть и с оговорками.

Легко можно получить и обратную ситуацию: взять ту же самую GTX 1080 Ti и запустить на ней игру в HD-разрешении с минимальными настройками графики — и тут даже Core i9-9900K не сможет подготовить для ней столько кадров в секунду, чтобы она была занята на 100%.

Так что тут можно сделать два вывода: во-первых, если видеокарта недогружена несильно, а итоговый fps вас устраивает — всегда можно еще немного увеличить настройки графики, чтобы получить 100% нагрузку на видеокарту с лучшей картинкой и при той же производительности. Во-вторых, собирайте сбалансированные сборки, дабы не было такого, что процессор занят на 100%, а fps в игре 20 кадров.

Восьмой миф. Если видеокарта не перегревается, то она работает на максимально возможной для нее частоте в рамках ее теплопакета

Увы — аналогия с процессорами тут не работает: если те действительно удерживают максимальные частоты в рамках TDP вплоть до температуры, с которой начинается троттлинг из-за перегрева, то видеокарты работают хитрее: так, у Nvidia есть технология GPU Boost, которая, с одной стороны, является аналогом Turbo Boost для процессоров — позволяет поднимать частоту выше базовой — а с другой стороны имеет больше ограничений.

Возьмем, для примера, GTX 1080 Ti. Она имеет родную частоту в 1480 МГц, а Boost — 1580. Но стоит нагрузить видеокарту, как частота может подскочить до 1800-1850 МГц — то есть выше Boost: это и есть работа технологии GPU Boost. Дальше — интереснее: критические температуры у видеокарт поколения Pascal составляют порядка 95 градусов — но уже при 85 можно заметить, что частоты снижаются ближе к уровню Boost. Почему так? Потому что Nvidia ввела еще одну опорную температуру, которую называет целевой: при ее достижении видеокарта старается ее не превышать, а для этого сбрасывает частоты. Так что если у вас мощная видеокарта, да и еще с референсным турбинным охлаждением — внимательно следите за температурами, ибо от них в прямом смысле зависит производительность.

Девятый миф. Видеокарты без дополнительного питания хуже аналогов с ним

В продаже можно встретить видеокарты уровня GTX 1050, 1050 Ti и AMD RX 550 без дополнительного питания — то есть, как в старые добрые времена, достаточно поставить их в слот PCIe и они готовы к работе. При этом также есть версии 1050 и 1050 Ti с дополнительным питанием 6 pin, из-за чего некоторые пользователи делают вывод, что раз дополнительное питание есть — значит с ним видеокарты будут работать лучше.

На деле это не совсем так: слот PCIe способен дать видеокарте до 75 Вт, и этого вполне хватает, чтобы даже 1050 Ti работала на указанных на официальном сайте Nvidia частотах. Но если вы нацелены на разгон — да, тут питания от PCIe видеокарте может уже не хватить, так что дополнительные 6 pin от блока питания позволят достичь больших частот, однако разница в любом случае не превысит 10%.

Десятый миф. Не стоит ставить современные PCIe 3.0 видеокарты на старые платы со слотами PCIe 2.0 или 1.0

Все опять же логично — так, пропускная способность PCIe 2.0 x16 вдвое ниже, чем у 3.0 x16, а, значит, современные видеокарты через более старую шину PCIe будут работать медленнее. На деле это опять же не так — пропускная способность PCI Express 3.0 x16 даже для топовых современных видеокарт оказывается избыточной:

Хорошо видно, что разница между 3.0 x16 и 2.0 x16 составляет всего 1%, то есть погрешность, и даже если спуститься до PCIe 1.1 — то есть к материнским платам почти десятилетней давности — падение производительности оказывается всего лишь 6%. Так что вердикт тут прост — версия PCIe практически не влияет на производительность видеокарты, соответственно можно смело к Xeon с PCI Express 2.0 брать GTX 1080.

Одиннадцатый миф. Разгон видеопамяти не имеет смысла

Конечно, наибольший прирост дает разгон ядра видеокарты — тут прирост производительности близок к линейному (то есть увеличили частоту на 10% — получили прирост производительности на 10%). Однако не стоит сбрасывать со счетов видеопамять, особенно в слабых видеокартах: зачастую в них ставят те же чипы памяти, что и в более мощные решения, но при этом сильно снижают частоту. Это дает возможность ее достаточно сильно разогнать, зачастую на 20-40%, что может прибавить к общей производительности графики еще 10-15% — для слабых видеокарт это лишним, разумеется, не будет:

Но почему тогда есть разница в производительности между драйверами? Потому что ничто в нашем мире не идеально, и какие-то драйвера, улучшая производительность в новых играх, могут испортить производительность в более старых или привести к различным ошибкам. Обычно через некоторые время выходят исправленные драйвера, и все возвращается на круги своя.

Читайте также: