Остаток от работы затраченной на компенсацию энтропии самого наблюдателя его неупорядоченности

Обновлено: 02.05.2024

Разрешите мне вернуться к последним фразам § 44. Там я пытался объяснить, что молекулярная теория гена сделала вполне допустимым то, что миниатюрный код точно соответствует весьма сложному и специфическому плану развития организма и каким-то образом содержит факторы, реализующие этот план. Но как он делает это? Как перейти от предположения к действительному пониманию?

Молекулярная модель Дельбрюка в ее совершенно общей форме не содержит, видимо, намеков на то, как действует наследственное вещество. И в самом деле, я не ожидаю, чтобы от физиков в ближайшем будущем могли быть получены сколько-нибудь подробные сведения. Определенные успехи в решении этой проблемы уже есть, и, я уверен, что они еще будут, но в области биохимии, особенно в связи с ее проникновением в область физиологии и генетики.

Никаких детальных данных о функционировании генного механизма нельзя извлечь из столь общего описания его структуры, какое дано выше. Это ясно. И тем не менее, как это ни странно, имеется одно общее представление, вытекающее из него, и оно-то, признаюсь, было единственной причиной, побудившей меня написать эту небольшую книгу.

Из общей картины наследственного вещества, нарисованной Дельбрюком, следует, что деятельность живой ма-

* Ни тело не может побуждать душу к мышлению, ни душа не может побуждать тело ни к движению, ни к покою, ни к чему-либо другому (если только есть что-нибудь такое). — Спиноза. Этика, ч. III, теор. 2.

терии, хотя и основана па законах физики, установленных к настоящему времени, но, по-видимому, подчиняется до сих пор неизвестным другим законам физики, которые, однако, как только они будут открыты, должны составить такую же неотъемлемую часть этой науки, как и первые.

53. Упорядоченность, основанная на “упорядоченности”

Эта довольно тонкая цепь рассуждений трудна для понимания, и все последующие страницы посвящены тому, чтобы сделать ее ясной. Предварительно, грубо, но не совсем неверно она может быть изложена следующим образом.

В главе I мы указали, что законы физики, как мы их знаем, — это статистические законы*. Они связаны с естественной тенденцией материи переходить к неупорядоченности.

Но чтобы примирить высокую устойчивость носителей наследственности с их малыми размерами и обойти тенденцию к неупорядоченности, нам пришлось “изобрести” молекулу — необычно большую молекулу, которая стала образцом высокодифференцированной упорядочности, охраняемой волшебной палочкой квантовой теории. Законы случайности не умаляются этим “изобретением”, но изменяется их проявление. Физик хорошо знает, что классические законы физики заменяются квантовой теорией, особенно при низкой температуре. Этому имеется много примеров. Жизнь представляется одним из них, особенно удивительным.

Жизнь — это упорядоченное и закономерное поведение материи, основанное не только на одной тенденции переходить от упорядоченности к неупорядоченности, но и частично на существовании упорядоченности, которая поддерживается все время.

Для физика (и только для него) я надеюсь пояснить свою точку зрения такими словами: живой организм представляется макроскопической системой, частично приближающейся в своих проявлениях к чисто механическому (по контрасту с термодинамическим) поведению, к которому стремятся все системы, когда температура приближается к абсолютному нулю и молекулярная неупорядоченность снимается.

* Такое совершенно общее утверждение о законах физики, возможно, покажется весьма сомнительным, но причина этого будет объяснена в главе VII.

Но нефизику трудно поверить, что обычные законы физики, которые он рассматривает как образец нерушимой точности, должны основываться на статистической тенденции материи переходить к неупорядоченности. Такие примеры я привел в главе I. Общим принципом здесь является знаменитый второй закон термодинамики (принцип энтропии) и его столь же знаменитое статистическое обоснование. В § 54—58 я попытаюсь кратко изложить принцип энтропии в приложении к основным проявлениям живого организма, забыв на время все, что известно о хромосомах, наследственности и т. д.

54. Живая материя избегает перехода к равновесию

Что является характерной особенностью жизни? Когда мы считаем материю живой? Тогда, когда она продолжает “делать что-либо”, двигаться, участвовать в обмене веществ с окружающей средой и т. д., — все это в течение более длительного отрезка времени, чем, по нашим ожиданиям, могла бы делать неодушевленная материя в подобных условиях. Если неживую систему изолировать или поместить в однородные условия, всякое движение обычно очень скоро прекращается в результате различного рода трения; разность электрических или химических потенциалов выравнивается, вещества, которые имеют тенденцию образовывать химические соединения, образуют их, температура выравнивается вследствие теплопроводности. Затем система в целом угасает, превращается в мертвую инертную массу материи. Достигается состояние, при котором не происходит никаких заметных событий. Физик называет это состояние термодинамическим равновесием, или состоянием максимальной энтропии.

Практически такое состояние обычно достигается весьма быстро. Теоретически очень часто это состояние еще не истинное равновесие, еще не действительный максимум энтропии. Окончательное установление равновесия происходит очень медленно. Оно может потребовать нескольких часов, лет, столетий. Приведем пример, когда приближение к равновесию происходит все же достаточно быстро. Если стакан, наполненный чистой водой, и другой, наполненный подслащенной водой, поместить в герметически закрытый ящик при достоянной температуре, то сначала как будто ничего не происходит, возникает впечатление полного равновесия. Но через день становится заметным, как чистая вода вследствие более высокого давления ее па-

ров постепенно испаряется и конденсируется на поверхности раствора сахара; последний переливается через край стакана. Только после того как чистая вода полностью испарится, сахар равномерно распределится по всему доступному ему объему.

Эти конечные этапы приближения к равновесию никогда не могут быть приняты за жизнь, и мы можем пренебречь ими. Я упоминаю о них, чтобы оградить себя от обвинения в неточности.

55. Питание “отрицательной энтропией”

Именно потому, что организм избегает быстрого перехода в инертное состояние “равновесия”, он и кажется загадочным. Настолько загадочным, что с древнейших времен человеческая мысль допускала действие в организме особой, какой-то не физической, а сверхъестественной силы (vis viva, энтелехия).

Как же живой организм избегает перехода к равновесию? Ответ достаточно прост: благодаря тому, что он питается, дышит и (в случае растений) ассимилирует. Для всего этого есть специальный термин — метаболизм. (Греческое слово μεταβάλλειυ ξзначает обмен.). Обмен чего? Первоначально, без сомнения, подразумевался обмен веществ (например, метаболизм, по немецки Stoffwechsel*). Но представляется нелепостью, чтобы главным был именно обмен веществ. Любой атом азота, кислорода, серы и т. п. так же хорош, как любой другой атом того же элемента. Что же достигается их обменом? Одно время наше любопытство удовлетворялось утверждением, что мы питаемся энергией. В ресторанах некоторых стран вы могли бы найти карточки-меню, указывающие цену каждого блюда и содержание в нем энергии (калорий). Нечего и говорить, что это нелепость, ибо во взрослом организме содержание энергии так же постоянно, как и содержание материи. Каждая калория, конечно, имеет ту же ценность, что и любая другая, поэтому нельзя понять, чему может помочь простой обмен этих калорий.

Что же тогда составляет то драгоценное нечто, содержащееся в нашей пище, что предохраняет нас от смерти? На это легко ответить. Каждый процесс, явление, событие (назовите его, как хотите), короче говоря, все, что происходит в Природе, означает увеличение энтропии в той части Вселенной, где это имеет место. Так и живой организм

* Буквально — обмен веществ. — Прим. перев.

непрерывно увеличивает свою энтропию, или, иначе производит положительную энтропию и, таким образов, приближается к опасному состоянию максимальной энтропии, представляющему собой смерть. Он может избежать этого состояния, то есть оставаться живым, только постоянно извлекая из окружающей его среды отрицательную энтропию, которая представляет собой нечто весьма положительное, как мы сейчас увидим. Отрицательная энтропия — это то, чем организм питается. Или, чтобы выразить это менее парадоксально, существенно в метаболизме то, что организму удается освобождаться от всей той энтропии, которую он вынужден производить, пока жив.

56. Что такое энтропия

Разрешите сначала подчеркнуть, что это не туманное представление или идея, а измеримая физическая величина, совершенно такая же, как длина стержня, температура любой точки тела, скрытая теплота плавления данного кристалла или удельная теплоемкость любого вещества. При температуре абсолютного нуля (грубо — 273° С) энтропия любого вещества равна нулю. Если вы будете медленно переводить вещество в любое другое состояние обратимыми небольшими этапами (даже если при этом вещество изменит свою физическую или химическую природу, распадется на две или большее число частей с различными физическими или химическими характеристиками), то энтропия возрастет на величину, которая определяется делением каждой малой порции тепла, затрачиваемой во время этой операции, на абсолютную температуру, при которой это тепло затрачено, а затем суммированием всех полученных величин. Например, когда вы расплавляете твердое тело, энтропия возрастает на величину теплоты плавления, деленной на температуру при точке плавления. Таким образом, вы видите, что единица измерения энтропии есть калория на градус (совершенно так же, как калория есть единица измерения тепла или сантиметр есть единица измерения длины).

57. Статистическое значение энтропии

Я привел это специальное определение для того, чтобы освободить энтропию от той атмосферы туманной загадочности, которой ее часто окружают. Гораздо более важна для нас связь энтропии со статистической концепцией упорядоченности и неупорядоченности — связь, открытая Больцманом и Гиббсом на основе данных статистической физики. Она также являет-

ся точной количественной связью и ее можно выразить так:

Энтропия = k lg D,

где k — так называемая постоянная Больцмана, равная 3,2983 •10 -24 калорий на градус Цельсия; D —количественная мера неупорядоченности атомов в рассматриваемом теле. Дать точное объяснение величины D в кратких и неспециальных терминах почти невозможно. Неупорядоченность, которую она выражает, отчасти заключается в тепловом движении, отчасти в том, что атомы и молекулы разного сорта смешиваются чисто случайно вместо того, чтобы быть полностью разделенными, как в недавно приведенном примере молекулы сахара и воды. Уравнение Больцмана хорошо иллюстрируется этим примером. Постепенное “распространение” сахара по всему объему воды увеличивает неупорядоченность D, и поэтому (поскольку логарифм D возрастает с увеличением D) возрастает и энтропия. Совершенно ясно, что всякий приток тепла извне увеличивает интенсивность теплового движения, то есть, иначе, увеличивает D и таким образом повышает энтропию. Что это именно так и есть, особенно наглядно проявляется тогда, когда вы расплавляете кристалл. При этом нарушается изящное и устойчивое расположение атомов или молекул и кристаллическая решетка превращается в непрерывно меняющееся случайное распределение атомов.

Изолированная система или система в однородных условиях (для наших рассуждений ее лучше учитывать как часть рассматриваемой системы) увеличивает свою энтропию и более или менее быстро приближается к инертномy состоянию максимальной энтропии. Мы узнаем теперь в этом основном законе физики естественное стремление материи приближаться к хаотическому состоянию, если мы не препятствуем этому.

58. Организация, поддерживаемая извлечением “упорядоченности” окружающей среды

Как в терминах статистической теории выразить ту удивительную способность живого организма, с помощъю которой он задерживает переход к термодинамическому равновесию (смерти)? Выше мы сказали: “Он питается отрицательной энтропией”, как бы привлекая на себя ее поток, чтобы компенсировать этим увеличение энтропии, производимое им в процессе жизни, и таким образом поддерживать себя на посстоянном и достаточно низком уровне энтропии.

Если D — мера неупорядоченности, то обратную величину 1/D можно рассматривать как прямую меру упорядоченности. Поскольку логарифм 1/D есть то же, что и отрицательный логарифм D, мы можем написать уравнение Больцмана таким образом:

— (Энтропия) = k lg (1/D).

Теперь неуклюжее выражение отрицательная энтропия можно заменить более изящным: энтропия, взятая с отрицательным знаком, есть сама по себе мера упорядоченности. Таким образом, средство, при помощи которого организм поддерживает себя постоянно на достаточно высоком уровне упорядоченности (равно на достаточно низком уровне энтропии), в действительности состоит в непрерывном извлечении упорядоченности из окружающей его среды. Это заключение менее парадоксально, чем кажется на первый взгляд. Скорее, оно тривиально. В самом деле, у высших животных мы достаточно хорошо знаем тот вид упорядоченности, которым они питаются, а именно: крайне хорошо упорядоченное состояние материи в более или менее сложных органических соединениях служит им пищей. После использования животные возвращают эти вещества s очень деградированной форме, однако не вполне деградированной, так как их еще могут употреблять растения. (Для растений мощным источником “отрицательной энтропии” является, конечно, солнечный свет.)

Энтропия. Пожалуй, это одно из самых сложных для понимания понятий, с которым вы можете встретиться в курсе физики, по крайней мере если говорить о физике классической. Мало кто из выпускников физических факультетов может объяснить, что это такое. Большинство проблем с пониманием энтропии, однако, можно снять, если понять одну вещь. Энтропия качественно отличается от других термодинамических величин: таких как давление, объём или внутренняя энергия, потому что является свойством не системы, а того, как мы эту систему рассматриваем. К сожалению в курсе термодинамики её обычно рассматривают наравне с другими термодинамическими функциями, что усугубляет непонимание.

Например, если вы спросите меня, где я живу, и я отвечу: в России, то моя энтропия для вас будет высока, всё-таки Россия большая страна. Если же я назову вам свой почтовый индекс: 603081, то моя энтропия для вас понизится, поскольку вы получите больше информации.

Почтовый индекс содержит шесть цифр, то есть я дал вам шесть символов информации. Энтропия вашего знания обо мне понизилась приблизительно на 6 символов. (На самом деле, не совсем, потому что некоторые индексы отвечают большему количеству адресов, а некоторые — меньшему, но мы этим пренебрежём).

Или рассмотрим другой пример. Пусть у меня есть десять игральных костей (шестигранных), и выбросив их, я вам сообщаю, что их сумма равна 30. Зная только это, вы не можете сказать, какие конкретно цифры на каждой из костей — вам не хватает информации. Эти конкретные цифры на костях в статистической физике называют микросостояниями, а общую сумму (30 в нашем случае) — макросостоянием. Существует 2 930 455 микросостояний, которые отвечают сумме равной 30. Так что энтропия этого макросостояния равна приблизительно 6,5 символам (половинка появляется из-за того, что при нумерации микросостояний по порядку в седьмом разряде вам доступны не все цифры, а только 0, 1 и 2).

А что если бы я вам сказал, что сумма равна 59? Для этого макросостояния существует всего 10 возможных микросостояний, так что его энтропия равна всего лишь одному символу. Как видите, разные макросостояния имеют разные энтропии.

Пусть теперь я вам скажу, что сумма первых пяти костей 13, а сумма остальных пяти — 17, так что общая сумма снова 30. У вас, однако, в этом случае имеется больше информации, поэтому энтропия системы для вас должна упасть. И, действительно, 13 на пяти костях можно получить 420-ю разными способами, а 17 — 780-ю, то есть полное число микросостояний составит всего лишь 420х780 = 327 600. Энтропия такой системы приблизительно на один символ меньше, чем в первом примере.

Мы измеряем энтропию как количество символов, необходимых для записи числа микросостояний. Математически это количество определяется как логарифм, поэтому обозначив энтропию символом S, а число микросостояний символом Ω, мы можем записать:

Это есть ничто иное как формула Больцмана (с точностью до множителя k, который зависит от выбранных единиц измерения) для энтропии. Если макросостоянию отвечают одно микросостояние, его энтропия по этой формуле равна нулю. Если у вас есть две системы, то полная энтропия равна сумме энтропий каждой из этих систем, потому что log(AB) = log A + log B.

Из приведённого выше описания становится понятно, почему не следует думать об энтропии как о собственном свойстве системы. У системы есть опеделённые внутренняя энергия, импульс, заряд, но у неё нет определённой энтропии: энтропия десяти костей зависит от того, известна вам только их полная сумма, или также и частные суммы пятёрок костей.

Другими словами, энтропия — это то, как мы описываем систему. И это делает её сильно отличной от других величин, с которыми принято работать в физике.

Классической системой, которую рассматривают в физике, является газ, находящийся в сосуде под поршнем. Микросостояние газа — это положение и импульс (скорость) каждой его молекулы. Это эквивалентно тому, что вы знаете значение, выпавшее на каждой кости в рассмотренном раньше примере. Макросостояние газа описывается такими величинами как давление, плотность, объём, химический состав. Это как сумма значений, выпавших на костях.

хотя вы, скорее всего, лучше знакомы с уравнением Клапейрона — Менделеева pV = νRT — это то же самое уравнение, только с добавлением пары констант, чтобы вас запутать. Чем больше микросостояний отвечают данному макросостоянию, то есть чем больше частиц входят в состав нашей системы, тем лучше уравнение состояния её описывают. Для газа характерные значения числа частиц равны числу Авогадро, то есть составляют порядка 10 23 .

Величины типа давления, температуры и плотности называются усреднёнными, поскольку являются усреднённым проявлением постоянно сменяющих друг друга микросостояний, отвечающих данному макросостоянию (или, вернее, близким к нему макросостояниям). Чтобы узнать в каком микросостоянии находится система, нам надо очень много информации — мы должны знать положение и скорость каждой частицы. Количество этой информации и называется энтропией.

Как меняется энтропия с изменением макросостояния? Это легко понять. Например, если мы немного нагреем газ, то скорость его частиц возрастёт, следовательно, возрастёт и степень нашего незнания об этой скорости, то есть энтропия вырастет. Или, если мы увеличим объём газа, отведя поршень, увеличится степень нашего незнания положения частиц, и энтропия также вырастет.

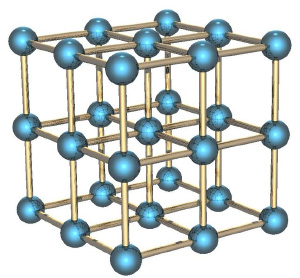

Если мы рассмотрим вместо газа какое-нибудь твёрдое тело, особенно с упорядоченной структурой, как в кристаллах, например, кусок металла, то его энтропия будет невелика. Почему? Потому что зная положение одного атома в такой структуре, вы знаете и положение всех остальных (они же выстроены в правильную кристаллическую структуру), скорости же атомов невелики, потому что они не могут улететь далеко от своего положения и лишь немного колеблются вокруг положения равновесия.

Если кусок металла находится в поле тяготения (например, поднят над поверхностью Земли), то потенциальная энергия каждого атома в металле приблизительно равна потенциальной энергии других атомов, и связанная с этой энергией энтропия низка. Это отличает потенциальную энергию от кинетической, которая для теплового движения может сильно меняться от атома к атому.

Если кусок металла, поднятый на некоторую высоту, отпустить, то его потенциальная энергия будет переходить в кинетическую энергию, но энтропия возрастать практически не будет, потому что все атомы будут двигаться приблизительно одинаково. Но когда кусок упадёт на землю, во время удара атомы металла получат случайное направление движения, и энтропия резко увеличится. Кинетическая энергия направленного движения перейдёт в кинетическую энергию теплового движения. Перед ударом мы приблизительно знали, как движется каждый атом, теперь мы эту информацию потеряли.

Второй закон термодинамики утверждает, что энтропия (замкнутой системы) никогда не уменьшается. Мы теперь можем понять, почему: потому что невозможно внезапно получить больше информации о микросостояниях. Как только вы потеряли некую информацию о микросостоянии (как во время удара куска металла об землю), вы не можете вернуть её назад.

Давайте вернёмся обратно к игральным костям. Вспомним, что макросостояние с суммой 59 имеет очень низкую энтропию, но и получить его не так-то просто. Если бросать кости раз за разом, то будут выпадать те суммы (макросостояния), которым отвечает большее количество микросостояний, то есть будут реализовываться макросостояния с большой энтропией. Самой большой энтропией обладает сумма 35, и именно она и будет выпадать чаще других. Именно об этом и говорит второй закон термодинамики. Любое случайное (неконтролируемое) взаимодействие приводит к росту энтропии, по крайней мере до тех пор, пока она не достигнет своего максимума.

И ещё один пример, чтобы закрепить сказанное. Пусть у нас имеется контейнер, в котором находятся два газа, разделённых расположенной посередине контейнера перегородкой. Назовём молекулы одного газа синими, а другого — красными.

Если открыть перегородку, газы начнут перемешиваться, потому что число микросостояний, в которых газы перемешаны, намного больше, чем микросостояний, в которых они разделены, и все микросостояния, естественно, равновероятны. Когда мы открыли перегородку, для каждой молекулы мы потеряли информацию о том, с какой стороны перегородки она теперь находится. Если молекул было N, то утеряно N бит информации (биты и символы, в данном контексте, это, фактически, одно и тоже, и отличаются только неким постоянным множителем).

Ну и напоследок рассмотрим решение в рамках нашей парадигмы знаменитого парадокса демона Максвелла. Напомню, что он заключается в следующем. Пусть у нас есть перемешанные газы из синих и красных молекул. Поставим обратно перегородку, проделав в ней небольшое отверстие, в которое посадим воображаемого демона. Его задача — пропускать слева направо только красных, и справа налево только синих. Очевидно, что через некоторое время газы снова будут разделены: все синие молекулы окажутся слева от перегородки, а все красные — справа.

Получается, что наш демон понизил энтропию системы. С демоном ничего не случилось, то есть его энтропия не изменилась, а система у нас была закрытой. Получается, что мы нашли пример, когда второй закон термодинамики не выполняется! Как такое оказалось возможно?

Решается этот парадокс, однако, очень просто. Ведь энтропия — это свойство не системы, а нашего знания об этой системе. Мы с вами знаем о системе мало, поэтому нам и кажется, что её энтропия уменьшается. Но наш демон знает о системе очень много — чтобы разделять молекулы, он должен знать положение и скорость каждой из них (по крайней мере на подлёте к нему). Если он знает о молекулах всё, то с его точки зрения энтропия системы, фактически, равна нулю — у него просто нет недостающей информации о ней. В этом случае энтропия системы как была равна нулю, так и осталась равной нулю, и второй закон термодинамики нигде не нарушился.

Но даже если демон не знает всей информации о микросостоянии системы, ему, как минимум, надо знать цвет подлетающей к нему молекулы, чтобы понять, пропускать её или нет. И если общее число молекул равно N, то демон должен обладать N бит информации о системе — но именно столько информации мы и потеряли, когда открыли перегородку. То есть количество потерянной информации в точности равно количеству информации, которую необходимо получить о системе, чтобы вернуть её в исходное состояние — и это звучит вполне логично, и опять же не противоречит второму закону термодинамики.

Читайте также: